GPU Destekli Özel Sunucular ile ChatGPT Tabanlı Kod Hata Ayıklama: Kontrol Sizde

Modern yazılım geliştirme süreçlerinde kod hatalarını hızlıca bulmak ve gidermek, projenin teslim süresi ve güvenilirliği açısından kritik öneme sahip. Bugün pek çok geliştirici, hata ayıklama (debugging) aşamasında ChatGPT gibi büyük dil modellerinden (LLM) yararlanıyor. Ancak bu modelleri doğrudan kitlesel bulut servisleri üzerinden kullanmak, farkında olunmayan ciddi riskler barındırıyor: kodunuzu üçüncü taraflara aktarmak, gizli iş mantığınızı ifşa etmek ve hatta regülasyon uyumunu tehlikeye atmak.

HatipTek olarak biz, “Teknolojiniz. Kontrolünüz Altında.” ilkesini benimseyerek, ChatGPT benzeri modelleri GPU destekli özel sunucular üzerinde çalıştırarak bu riskleri ortadan kaldırıyoruz. Böylece hata ayıklama sürecinde kullandığınız kod, tamamen sizin altyapınızda kalıyor.

Kitlesel Bulut ile Debugging: Görünmeyen Riskler

Bulut tabanlı ChatGPT API’leri, her sorguda kodunuzu üçüncü tarafın veri merkezlerine gönderir. Bu durum:

– Veri Gizliliği İhlali: Özel algoritmalar veya müşteri verileri, veri işleme sırasında dış sistemlere aktarılır.

– Kontrol Kaybı: Model sürümü, erişim politikası ve işlem kapasitesi tamamen servis sağlayıcı tarafından belirlenir.

– Performans Belirsizliği: Yüksek trafikte API yanıt süreleri artabilir; hata ayıklama süreci yavaşlar.

Özellikle fintech, savunma teknolojileri veya AR-GE projelerinde bu riskler kabul edilemez düzeydedir.

Özel GPU Sunucular ile ChatGPT Debugging

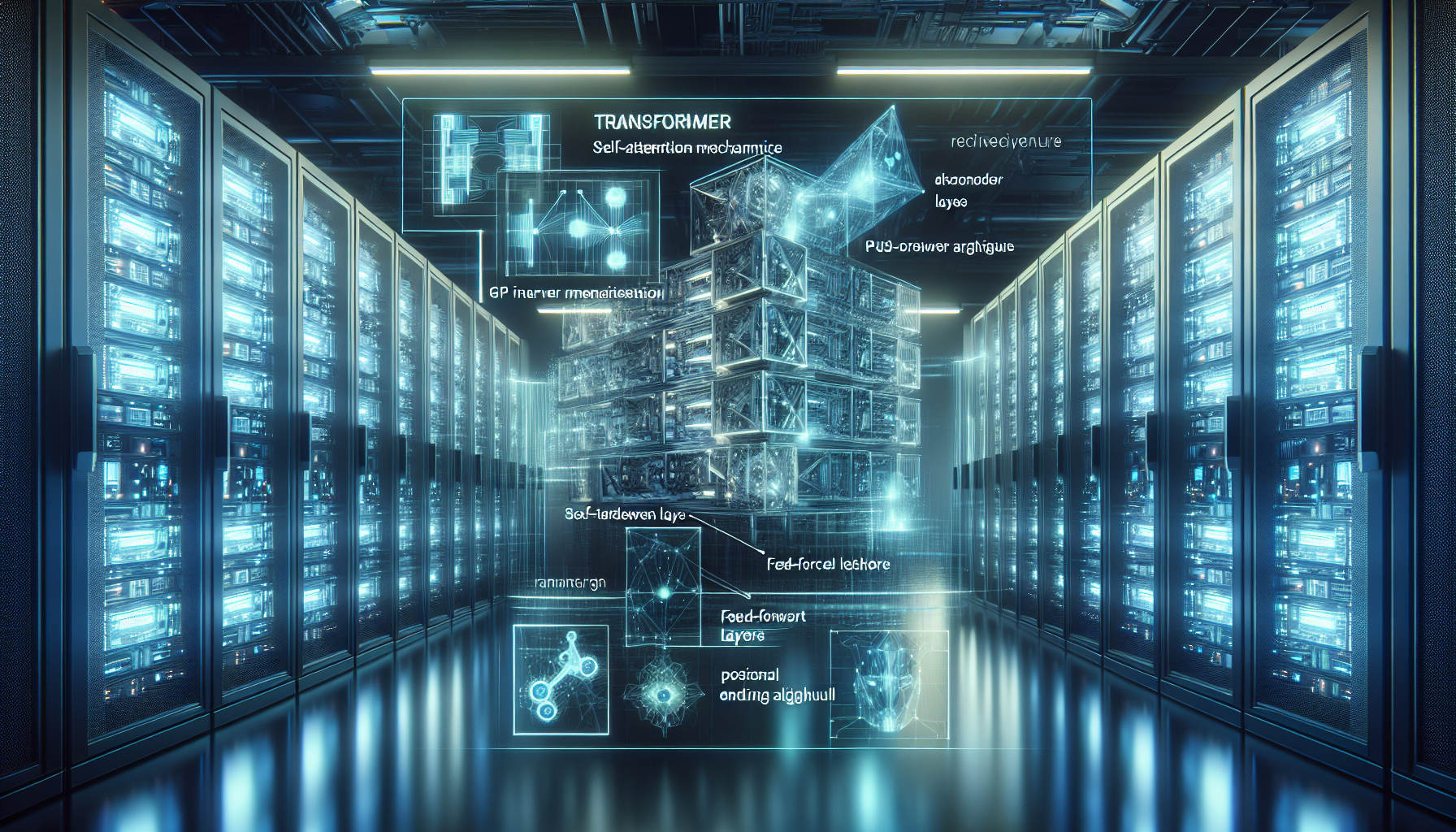

HatipTek’in önerdiği yaklaşım, kendi altyapınızda barındırılan bir LLM (örneğin open-source GPT benzeri modeller) ile kod hatalarını ayıklamaktır.

Teknik Avantajlar:

– Yüksek VRAM Kapasitesi: NVIDIA A100 veya RTX 6000 GPU’lar sayesinde milyonlarca parametreli modelleri düşük gecikme ile çalıştırabilirsiniz.

– Yerel Kod Analizi: Kodunuz sunucu dışına çıkmaz; tamamen güvenli ve izole bir debugging ortamı oluşur.

– Özelleştirilebilir Model: Modeli kendi kod tabanınıza göre fine-tune ederek, hata tespit doğruluğunu artırabilirsiniz.

– Anlık ve Offline Çalışma: İnternet bağlantısına gerek kalmadan, özel veri setleri ile modelden yanıt alınabilir.

Stratejik ve Finansal Perspektif: TCO Analizi

Bulut tabanlı API ücretleri, özellikle sık debugging yapan ekiplerde hızla artar. Kendi GPU sunucunuzu kurduğunuzda:

– Sabit Maliyet: Donanım yatırımı başlangıçta yüksek olsa da, uzun vadede API kullanım ücretlerinden kurtulursunuz.

– Öngörülebilir Performans: Sunucu donanımı size ait olduğu için işlem kapasitesi değişmez.

– ROI: 12-18 ay içinde, yoğun kullanım senaryolarında yatırım kendini amorti eder.

Uygulama Senaryosu

Bir yazılım ekibi, mikroservis tabanlı bir backend projesinde sık sık “null reference” ve concurrency hatalarıyla karşılaşıyor. Özel GPU sunucularında çalışan ChatGPT türevi model, kodu satır satır analiz ederek olası hata noktalarını işaretliyor. Model, ekibin önceki hata kayıtlarından öğrendiği için benzer hataları daha hızlı tespit ediyor. Tüm süreç, kurum içi ağda gerçekleştiği için kod güvenliği tam kontrol altında kalıyor.

Sonuç

Kod hatalarını ayıklamak için ChatGPT gibi LLM’lerden yararlanmak, doğru altyapı seçildiğinde hem verimli hem güvenli bir süreç olabilir. Kitlesel bulut yerine GPU destekli özel sunucular, verinizi koruyarak modelin gücünden en yüksek performansla yararlanmanızı sağlar. Bu yaklaşım, yazılım geliştirme sürecinizde hem teknik hem stratejik bir üstünlük sağlar.

Siz de hata ayıklama süreçlerinizde dijital egemenliğinizi koruyacak özel GPU çözümleri hakkında daha fazla bilgi almak için buradan bizimle iletişime geçebilirsiniz.

Bir yanıt yazın