GPU Tabanlı Çıkarım Motorlarında VRAM Ek Yükü: CUDA Çekirdekleri ve İşletim Sistemi Perspektifi

Yapay zeka çıkarım (inference) süreçlerinde, GPU sunucularının performansını belirleyen en kritik kaynaklardan biri VRAM’dir. Ancak çoğu teknik profesyonel, model parametreleri için ayrılan bellek dışında, CUDA çekirdeklerinin çalışma gereksinimleri ve işletim sisteminin GPU bellek kullanımı nedeniyle oluşan ek yük (overhead) faktörünü göz ardı eder. Bu ek yük, özellikle büyük dil modelleri (LLM) veya yüksek çözünürlüklü görsel işleme görevlerinde, performans ve kapasite planlamasında doğrudan belirleyici olur.

Standart Yaklaşımın Yetersizliği

Kitlesel bulut GPU kiralama servislerinde, VRAM tahsisi çoğu zaman toplam donanım kapasitesi üzerinden pazarlanır. Ancak:

– Çıkarım motorunun kendisi (TensorRT, PyTorch, ONNX Runtime vb.) GPU üzerinde ek bellek tüketir.

– CUDA çekirdeklerinin verimli çalışabilmesi için gerekli kernel buffer alanları VRAM’den karşılanır.

– İşletim sistemi (Linux veya Windows Server) ve GPU sürücüsü, model yüklenmese dahi bir taban bellek rezervasyonu yapar.

Bulut sağlayıcılar bu overhead’i çoğu zaman kullanıcıya net olarak raporlamaz. Sonuçta “16 GB VRAM” diye kiraladığınız bir GPU, çıkarım sırasında efektif olarak 13–14 GB kullanılabilir hale gelir. Bu, model yüklenememe, batch size düşürme veya inference hızının yavaşlaması gibi sonuçlar doğurur.

Teknik Analiz: VRAM Ek Yükünün Bileşenleri

- İşletim Sistemi ve Sürücü Ek Yükü

- NVIDIA sürücüleri ve CUDA runtime başlatıldığında, genellikle 300–800 MB arası VRAM rezerve edilir.

-

GUI tabanlı sistemlerde bu rakam daha da artar; headless (grafik arayüzsüz) bir Linux sunucu bu ek yükü minimize eder.

-

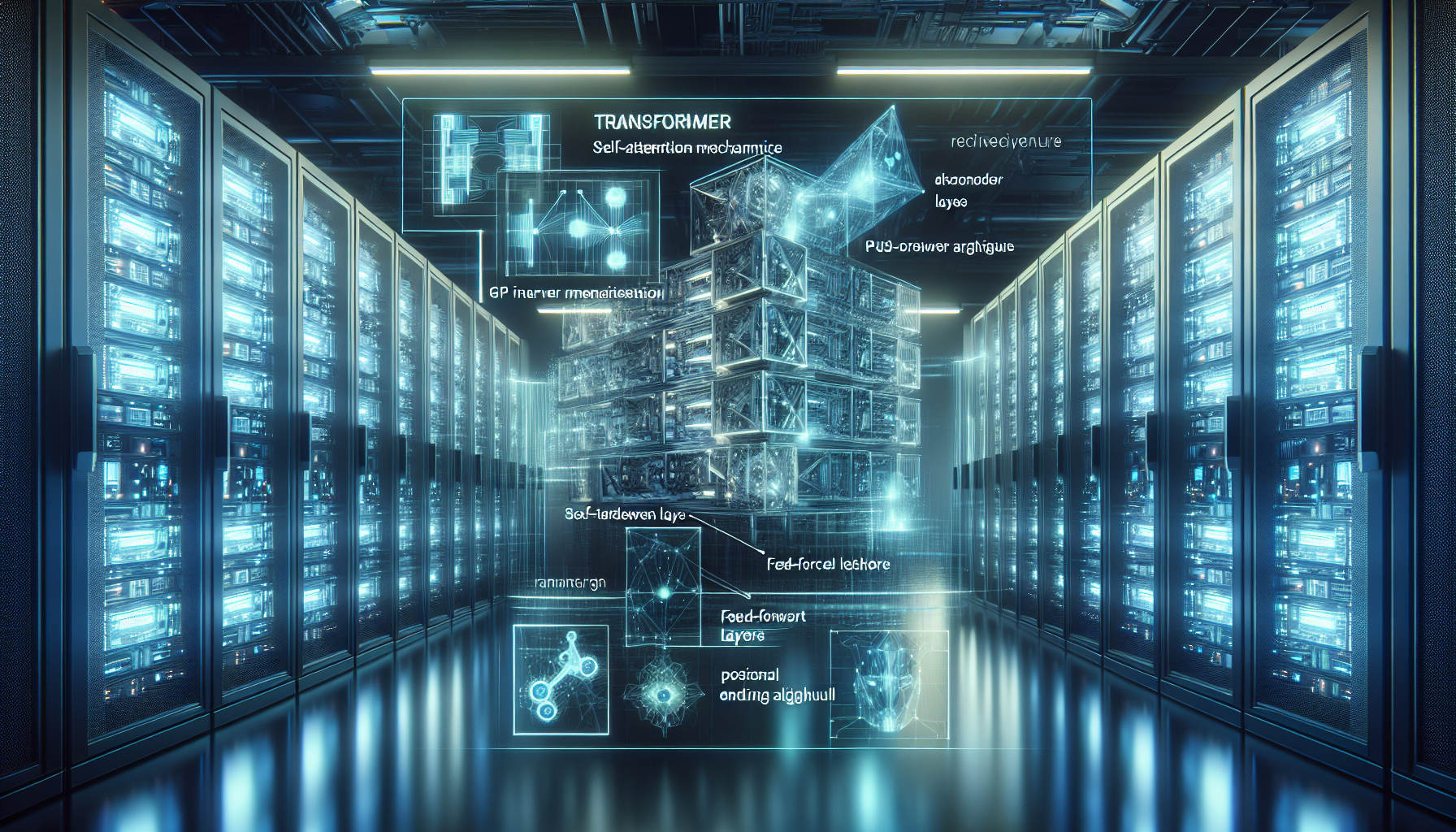

CUDA Çekirdekleri ve Kernel Buffer’lar

- CUDA çekirdekleri, paralel işlem bloklarının koordinasyonu için global ve shared memory alanlarını VRAM üzerinde ayırır.

-

TensorRT veya PyTorch, optimize edilmiş kernel setleri yüklerken 1–2 GB’a varan ek yük oluşturabilir.

-

Inference Framework Bellek Yönetimi

- Modelin kendisi VRAM’e yüklendiğinde, ek olarak tensor cache, workspace memory ve activation buffer alanları tahsis edilir.

-

Örneğin 13 GB’lık bir LLM modeli (FP16 formatında) için, inference motoru toplamda 15 GB VRAM talep edebilir.

-

Batch Size ve Pipeline Ek Yükü

- Batch size arttıkça, activation buffer boyutu katlanarak büyür.

- Pipeline paralelliği (ör. RAG entegrasyonu veya multi-stream inference) her stream için ek tahsis yapar.

Stratejik Çözüm: HatipTek’in Özel GPU Sunucu Altyapısı

HatipTek olarak, Teknolojiniz. Kontrolünüz Altında. ilkesine bağlı kalıyoruz. Bu nedenle, GPU tabanlı çıkarım motorları için VRAM ek yükünü şeffaf şekilde analiz edip, donanım kapasitesini gerçek kullanılabilir bellek üzerinden planlıyoruz.

- Headless Linux Konfigürasyonu ile işletim sistemi ek yükünü minimize ediyoruz.

- CUDA çekirdek optimizasyonu ve TensorRT tuning ile kernel buffer kullanımını dengeliyoruz.

- VRAM tahsisini model + ek yük toplamına göre yaparak, batch size hedeflerinizi garantiliyoruz.

- Paylaşımlı bulut yerine tamamen size ait fiziksel GPU sunucu sağlayarak, VRAM kapasitesinin başka kullanıcılar tarafından tüketilmesini engelliyoruz.

TCO Perspektifi

Kendi GPU altyapınızda, ek yük faktörünü baştan hesaba katmak:

– Gereksiz büyük model kiralamalarını önler.

– Tahsisli donanımda VRAM kapasitesi tam olarak size ait olur.

– Toplam Sahip Olma Maliyeti (TCO) uzun vadede %20–30 oranında düşer.

Sonuç

VRAM ek yükü, GPU çıkarım motorlarının gizli maliyetlerinden biridir. Bu yükü hesaba katmadan yapılan kapasite planlaması, performans darboğazlarına ve gereksiz harcamalara yol açar. HatipTek’in özel GPU sunucu çözümleri ile, modelinizin gerçek ihtiyaçlarını karşılayan ve size tam kontrol sağlayan bir altyapı kurabilirsiniz.

Detaylı bilgi ve stratejik GPU altyapı planlaması için buradan bize ulaşabilirsiniz.

Bir yanıt yazın