GPU Sunucu Ortamında Gruplama Stratejisinin TTFT ve Algılanan Gecikmeye Etkisi

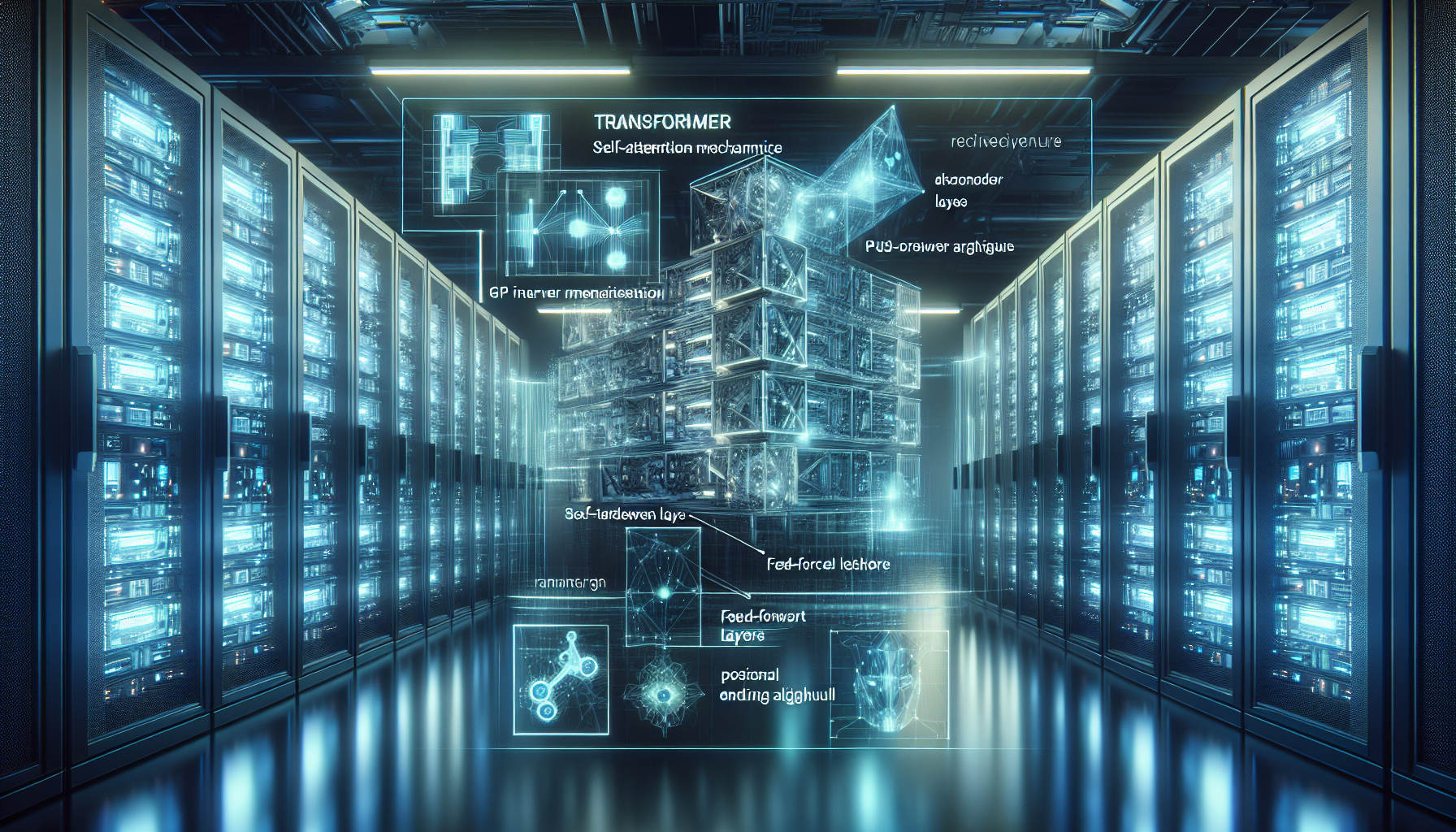

TTFT (Time to First Token), yapay zeka çıkarım altyapılarında kullanıcı deneyiminin en kritik metriklerinden biridir. Özellikle LLM tabanlı uygulamalarda, ilk cevabın ne kadar hızlı geldiği, sistemin “tepkiselliği” ve algılanan performansı doğrudan etkiler. Ancak bu metrik yalnızca GPU hızına değil, aynı zamanda isteklerin nasıl gruplandığı (batching) stratejisine de bağlıdır. Doğru gruplama, GPU verimliliğini artırırken; yanlış senaryo, TTFT’yi ve kullanıcı tarafındaki gecikme algısını dramatik şekilde bozabilir.

Gruplama Stratejisinin Teknik Boyutu

GPU tabanlı inference sunucuları, gelen istekleri batch halinde işlediğinde çekirdek ve bellek kaynaklarını daha verimli kullanır. Özellikle yüksek VRAM’e sahip kartlarda (ör. NVIDIA A100, H100 veya RTX 6000 Ada), aynı anda birden fazla isteği işlemek TFLOPS kapasitesini daha iyi değerlendirir.

Ancak burada iki kritik parametre devreye girer:

- Batch Size

- Daha büyük batch, GPU’nun paralel hesaplama gücünü maksimize eder.

-

Fakat batch tamamlanmadan işleme başlamaz, bu da TTFT’yi uzatabilir.

-

Batching Window (Bekleme Süresi)

- İsteklerin gruplanması için kullanılan zaman penceresidir.

- Çok uzun pencere, GPU verimini artırırken, kullanıcı deneyimini olumsuz etkiler.

Örnek:

Bir LLM sunucusu, her 50 ms’de gelen istekleri batch halinde işliyor olsun. Eğer ortalama kullanıcı trafiği düşükse, bu bekleme penceresi TTFT’yi gereksiz yere artırır. Yüksek trafikte ise GPU verimliliği artar ve toplam throughput yükselir.

TTFT vs. Algılanan Gecikme

TTFT, sistemin ilk cevabı üretmeye başlama süresi iken, algılanan gecikme (perceived latency) kullanıcının cevabı “tam olarak” alana kadar geçen süreyi ifade eder. Gruplama stratejiniz:

- TTFT’yi artırabilir: Batch toplamak için bekleme yapılırsa, ilk token gecikir.

- Algılanan gecikmeyi azaltabilir: GPU verimliliği artar, toplam cevap üretim hızı yükselir ve uzun yanıtlar daha akıcı gelir.

Bu nedenle, optimum strateji TTFT ile throughput arasında denge kurmaktır.

Kitlesel Bulut vs. Özel GPU Sunucu Yaklaşımı

Kitlesel bulut servislerinde batching parametreleri genellikle platformun genel verimliliği için optimize edilir, sizin spesifik TTFT hedefleriniz için değil. Bu da:

– Trafiğiniz azsa gereksiz TTFT artışı,

– Trafiğiniz yoğun ama özel modeliniz varsa GPU kapasitesinin tam kullanılmaması,

– Parametreleri değiştirme yetkisinin olmaması gibi kısıtlar getirir.

HatipTek’in özel GPU sunucu altyapısında ise:

– Batch size ve pencere süresi tamamen sizin kontrolünüzdedir.

– Trafik profilinize uygun dinamik batching kuralları uygulanabilir.

– TTFT hedeflerinize göre CUDA kernel optimizasyonu ve model quantization seçenekleri devreye alınabilir.

– Gecikme ölçümleri ve TCO analizine göre strateji sürekli optimize edilir.

Stratejik Öneri: TTFT – Throughput Dengesi

- Trafik Profilini Analiz Edin

Düşük trafikte küçük batch size, yüksek trafikte ise büyük batch size tercih edin. - Dinamik Batching Uygulayın

Trafiğe göre pencere süresini otomatik değiştiren sistemler kurun. - GPU Özelliklerini Kullanın

Multi-Stream CUDA optimizasyonları ile hem TTFT hem throughput iyileştirilebilir. - Özel Altyapı Sahipliği

Parametreleri değiştirme özgürlüğü, TTFT üzerinde doğrudan kontrol sağlar.

Sonuç:

Gruplama stratejiniz, TTFT ve algılanan gecikme üzerinde doğrudan belirleyici bir faktördür. Kitlesel altyapılarda bu denge genellikle sizin ihtiyaçlarınıza değil, platformun genel optimizasyon politikalarına göre ayarlanır. Kendi GPU sunucunuzu yönetmek, hem kullanıcı deneyimini hem de operasyonel verimliliği sizin lehine optimize etmenin tek garantili yoludur.

Daha düşük TTFT ve yüksek throughput için özel GPU sunucu stratejinizi birlikte kurgulamak isterseniz buradan bize ulaşabilirsiniz.

Bir yanıt yazın