Yapay Zeka Modeliniz Tek GPU’da mı Çalışmalı, Yoksa Tensör Paralelliğine mi İhtiyacınız Var?

Yapay zeka altyapısı kurarken kritik bir karar noktası, modelinizin tek bir GPU’nun VRAM kapasitesine sığıp sığmadığını veya çoklu GPU dağıtımı (tensör paralelliği) gerektirip gerektirmediğini belirlemektir. Bu karar, yalnızca teknik değil, aynı zamanda stratejik bir maliyet ve kontrol meselesidir.

Sorunun Temeli: VRAM ve Model Boyutu

Modern dil modelleri ve görüntü işleme ağları, parametre sayısına ve kullanılan veri tipine göre farklı VRAM gereksinimlerine sahiptir. Örneğin:

- FP32 (32-bit floating point) ağırlıklar: Daha yüksek doğruluk, ancak 2 kat daha fazla VRAM tüketimi.

- FP16 / BF16 (yarı hassas formatlar): VRAM kullanımını yarıya indirir, performans artışı sağlar.

- INT8 / INT4 (kuantize edilmiş formatlar): VRAM tüketimini ciddi oranda düşürür, ancak doğruluk kaybı riski vardır.

Pratik olarak:

– 7B parametreli bir LLM, FP16 formatında yaklaşık 14 GB VRAM gerektirir.

– 13B parametreli bir LLM ise FP16’da 26 GB VRAM civarındadır.

– 70B parametreli bir model FP16’da tek GPU’ya sığmaz; tensör paralelliği veya model paralelliği gerekir.

Kitlesel Bulutun Kör Noktası

Bulut sağlayıcılar genellikle “tek GPU” veya “çoklu GPU” seçeneklerini paket olarak sunar, ancak:

– Kaynak paylaşımı vardır: GPU’lar başka kullanıcılarla aynı fiziksel altyapıyı kullanabilir.

– Maliyet şeffaflığı eksik: Gerçek VRAM kullanımınız ile fatura kalemleri uyuşmayabilir.

– Veri kontrolü riski: Model ağırlıklarınız ve inference veriniz, sizin denetiminiz dışında depolanabilir.

Bu, özellikle özel veriyle eğitilmiş modeller için kabul edilemez riskler doğurur.

HatipTek Yaklaşımı: Kontrol Sizde

HatipTek olarak, modelinizin VRAM gereksinimini net biçimde hesaplayıp, tek GPU üzerinde maksimum verim alacak donanımı veya çoklu GPU tensör paralelliği için özel olarak yapılandırılmış sunucuları sağlıyoruz.

Tek GPU Senaryosu

- Avantaj: Basit mimari, düşük gecikme, bakım kolaylığı.

- Önerilen Donanım: NVIDIA RTX 6000 Ada (48 GB VRAM) veya A100 80 GB.

- Kullanım Örneği: 7B–13B parametreli LLM’ler, orta ölçekli görsel modeller.

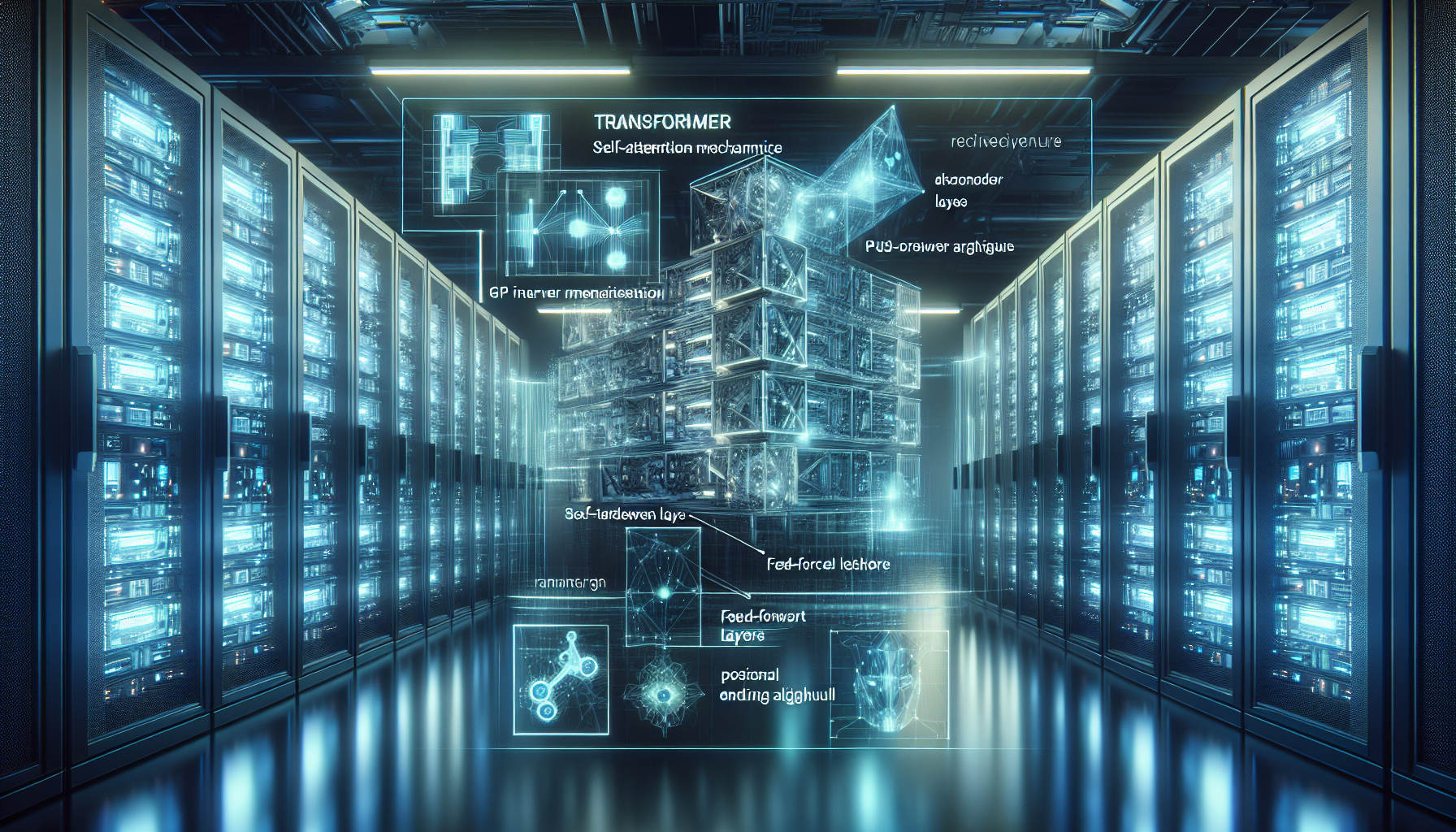

Tensör Paralelliği Senaryosu

- Avantaj: VRAM sınırlarını aşan modelleri çalıştırma (ör. 70B LLM).

- Önerilen Donanım: NVLink ile bağlı çoklu A100 / H100 kümeleri.

- Kullanım Örneği: Çok büyük parametreli modeller, gerçek zamanlı çoklu sorgu işleme.

Stratejik Karar: TCO ve ROI

- TCO (Toplam Sahip Olma Maliyeti): Tek GPU çözümü genellikle daha düşük başlangıç maliyeti sağlar, ancak gelecekte model boyutları büyüdükçe yeniden yatırım gerekebilir.

- ROI (Yatırımın Geri Dönüşü): Eğer modeliniz uzun vadede büyük VRAM gerektirecekse, baştan tensör paralelliği altyapısına yatırım yapmak, ölçeklenme sırasında maliyet ve zaman kazandırır.

Sonuç

Modelinizin tek GPU VRAM’ine sığıp sığmadığını bilmek, sadece teknik bir parametre değil; altyapı stratejinizin yönünü belirleyen kritik bir karardır. HatipTek, bu kararı şeffaf teknik analiz ve özel donanım konfigürasyonları ile destekleyerek, kontrolü tamamen size bırakır.

Teknolojiniz. Kontrolünüz Altında.

Altyapı gereksiniminizi netleştirmek ve size özel GPU sunucu yapılandırması için buradan bize ulaşabilirsiniz.

Bir yanıt yazın