Yapay Zeka Sunucularında S23-S25 Trafik Tahminlerine Göre Ağ Bant Genişliği Seçimi

Dijital altyapınızın geleceğini planlarken, özellikle GPU tabanlı yapay zeka çıkarım (inference) sunucularında ağ bant genişliği seçimi, performans ve ölçeklenebilirlik açısından kritik bir parametredir. S23-S25 dönemine ait trafik tahminleri, yalnızca işlem gücü değil, veri akışının gecikmesiz sağlanması açısından da stratejik kararlar gerektirir.

Neden Kitlesel Çözümler Yetersiz Kalır?

Büyük bulut sağlayıcıları, paylaşımlı ağ altyapısında oversubscription (fazla abonelik) oranlarını yüksek tutar. Bu, teorik olarak 10 GbE bağlantınız olsa bile, pratikte daha düşük hızlar ve tutarsız gecikmelerle karşılaşmanız anlamına gelir. Özellikle LLM tabanlı API servisleri, GPU ile CPU arasındaki veri aktarımında milisaniyeler düzeyinde gecikmeye karşı hassastır. Kontrolün sizde olmadığı her katman, tahmin edilebilir performansı ortadan kaldırır.

Teknik Analiz: Trafik Tahminlerinden Bant Genişliği Hesabı

Ağ genişliğini doğru belirlemek için üç ana parametreye bakılır:

- Eş zamanlı oturum sayısı (Concurrency)

-

Saniyede 500 istek ile çalışan bir inference sunucusu, her istekte ortalama 2 MB veri giriş/çıkış ile yaklaşık 8 Gbps trafik üretir.

-

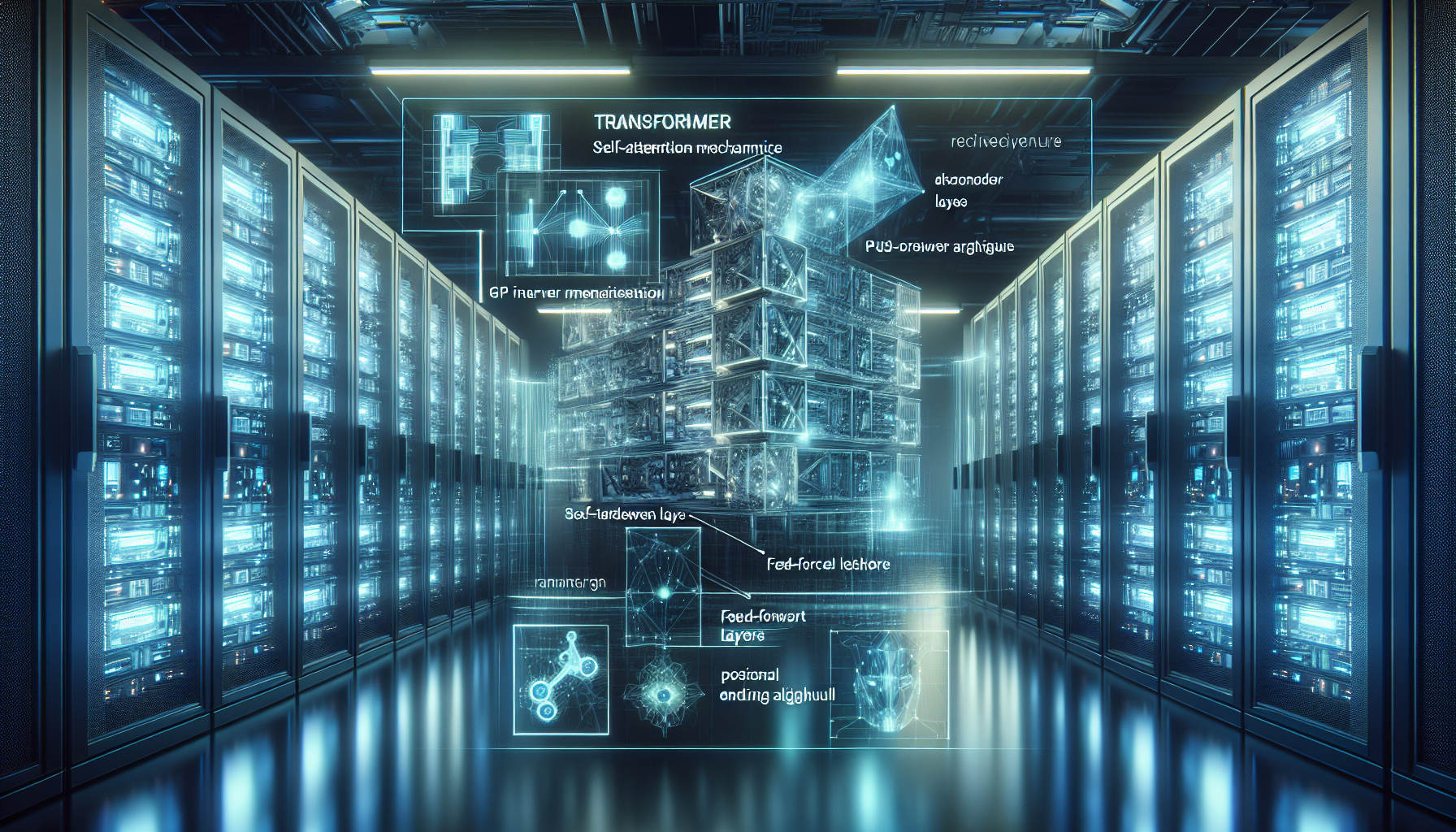

GPU Veri Transferi

- Model yükleme, batch inference ve sonuç iletiminde VRAM’den sistem belleğine ve oradan ağ kartına veri akışı olur.

-

Örneğin, 175 milyar parametreli bir LLM modelinde tek batch inference için ağ üzerinden 1-1.5 GB veri çıkışı gerekebilir.

-

Gecikme ve QoS (Quality of Service)

- AI servislerinde latency hedefiniz 50 ms altı ise, bant genişliği kadar paket işleme kapasitesi ve ağ altyapısının jitter kontrolü önemlidir.

Önerilen Bant Genişliği Senaryoları (S23-S25 Tahminleri)

| Trafik Seviyesi | Eş zamanlı İstek | Tahmini Gbps Yük | Önerilen Bağlantı | Stratejik Not |

|—————–|——————|——————|——————|—————|

| Düşük (Geliştirme/POC) | 50-100 | 1-2 Gbps | 1 GbE | Tek GPU, sınırlı model boyutları |

| Orta (Küçük Ölçekli Prod.) | 200-500 | 8-15 Gbps | 10 GbE | 2-4 GPU, küçük/orta LLM modelleri |

| Yüksek (Kurumsal AI API) | 1000+ | 20-40 Gbps | 25 GbE | Çok GPU’lu inference cluster |

| Kritik Ölçek (Gerçek Zamanlı AI) | 3000+ | 50-80+ Gbps | 100 GbE | HPC, büyük LLM, video+AI analizi |

HatipTek Yaklaşımı: Tam Kontrol ve Ölçeklenebilirlik

HatipTek, bant genişliği planlamasında yalnızca port hızı değil, uçtan uca veri yolu optimizasyonu sağlar:

– Özel GPU Sunucu Konfigürasyonu: PCIe 4.0/5.0 ve NVLink destekli, ağ kartıyla GPU arasındaki darboğazı kaldıran topolojiler.

– Bağımsız Ağ Segmentasyonu: AI inference trafiğini yönetim trafiğinden ayırarak QoS garantisi.

– Sahip Olma Maliyeti (TCO) Avantajı: 100 GbE gibi yüksek hızlarda bulut kiralama yerine kendi altyapınızda amortisman süresini kısaltma.

Sonuç

S23-S25 döneminde beklenen trafik artışınızı doğru bant genişliği ile eşleştirmek, yalnızca hız değil, kesintisiz kontrol anlamına gelir. AI sunucularınızın ağ katmanını kendi altyapınızda tasarlayarak, bulutun belirsizliğinden kurtulup öngörülebilir performans elde edersiniz.

Kendi GPU tabanlı AI altyapınız için doğru bant genişliği ve donanım stratejisini birlikte planlamak için bizimle iletişime geçebilirsiniz: HatipTek İletişim

Bir yanıt yazın