LLM Performansında Kritik Metrik: İlk Token Gecikmesi ve Token Başına Çıktı Süresi

Büyük dil modelleri (LLM) ile çalışan her özel GPU sunucusu projesinde, performans ölçümünün en kritik iki parametresi ilk token gecikmesi (first token latency) ve token başına çıktı süresi (per-token latency) olarak öne çıkar. Bu metrikler, modelin gerçek zamanlı veya toplu işleme senaryolarında ne kadar verimli çalıştığını doğrudan belirler. Özellikle kendi altyapınızı yönettiğiniz durumlarda, bu değerler yatırımın geri dönüşünü ve kullanıcı deneyimini optimize etmek için stratejik yol haritasının merkezinde yer alır.

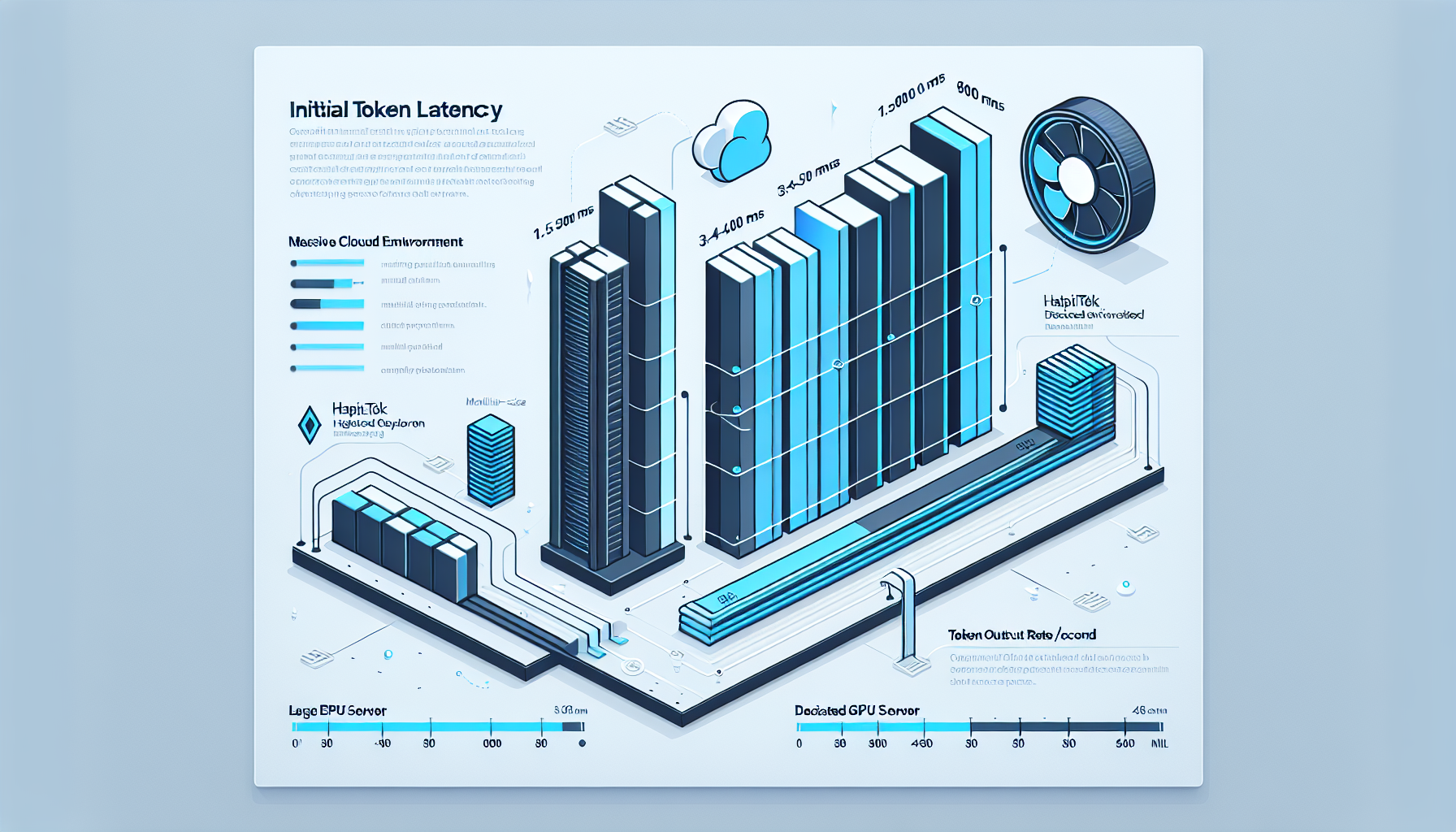

1. İlk Token Gecikmesi: Çıktının Başlangıç Noktası

LLM’ler, ilk token’ı üretmeden önce model yükleme, prompt işleme ve attention ön hesaplamaları gibi bir dizi işlem gerçekleştirir. Bu nedenle ilk token gecikmesi genellikle token başına üretim süresinden çok daha uzundur.

– Tipik Kitlesel Bulut Senaryosu: 1,5 – 4 saniye (paylaşımlı donanım ve yoğun trafik nedeniyle)

– Özel GPU Sunucu Senaryosu (HatipTek): 400 – 900 ms (NVMe tabanlı hızlı veri erişimi + VRAM’de ön yüklü model)

Bu fark, gerçek zamanlı sohbet uygulamaları, müşteri destek botları veya anlık kod öneri sistemleri gibi düşük gecikme gerektiren çözümlerde kritik öneme sahiptir.

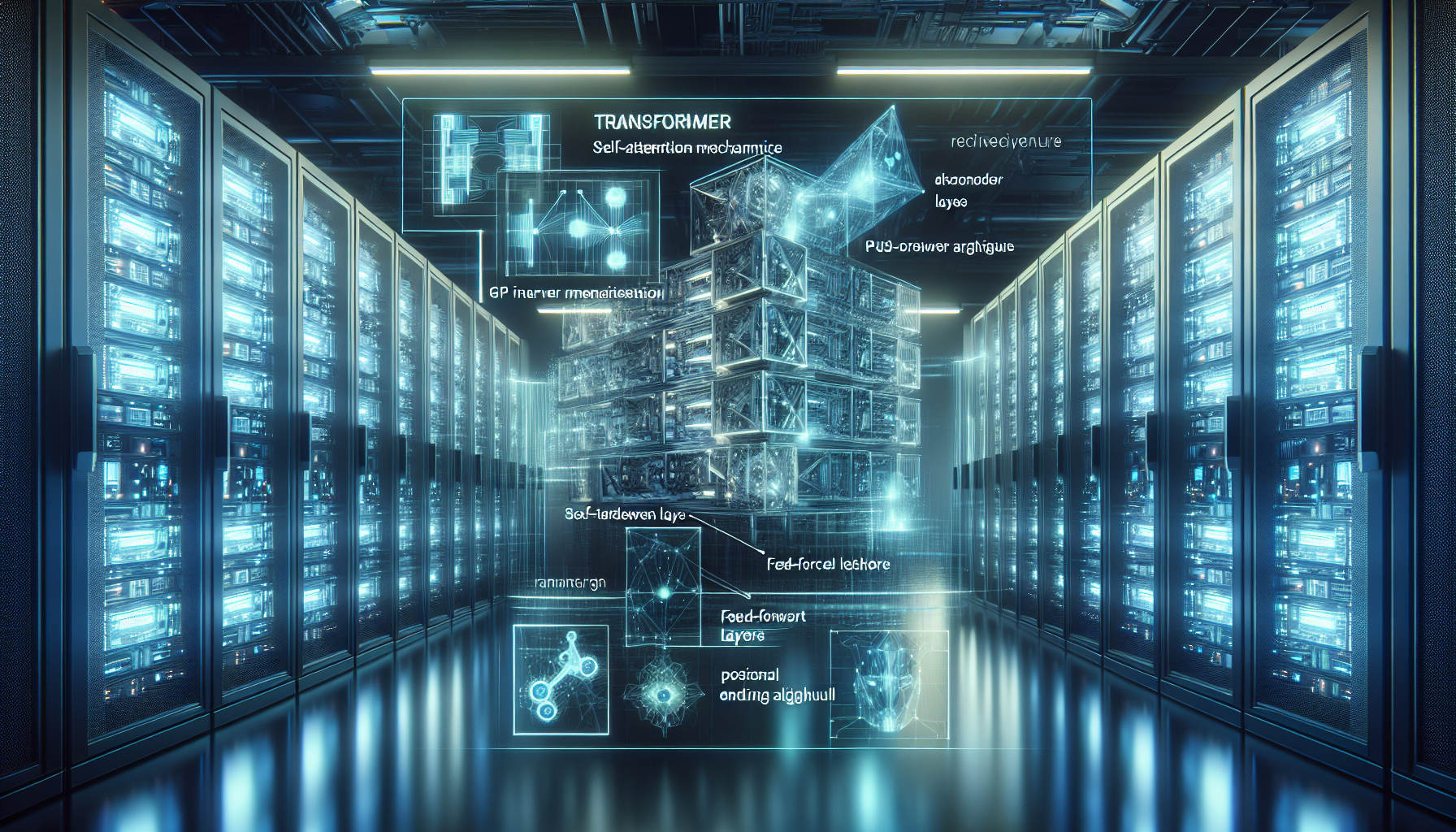

2. Token Başına Çıktı Süresi: Sürdürülebilir Hız

İlk token çıktıktan sonra model, her yeni token için sadece önceki bağlamın işlenmesini yapar. Buradaki hedef, saniye başına üretilen token sayısını (TPS) artırarak yanıt süresini düşürmektir.

– Hedeflenen Performans (Inference Optimizasyonu ile):

– Orta ölçekli LLM (7B parametre): 35 – 50 token/saniye (FP16)

– Büyük ölçekli LLM (70B parametre): 8 – 15 token/saniye (FP16)

– Kitlesel Servislerde Tipik Değerler: 5 – 20 token/saniye (paylaşımlı GPU ve model optimizasyon eksikliği nedeniyle)

Bu hızların elde edilmesinde etkili faktörler:

1. GPU Bellek Kapasitesi (VRAM) – Modelin tamamının VRAM’e sığması, CPU-RAM veri aktarım gecikmesini ortadan kaldırır.

2. Model Optimizasyonu – Quantization (INT8, FP8) ve tensor parallelism teknikleri ile throughput ciddi oranda artırılabilir.

3. Inference Motoru Seçimi – vLLM, TensorRT-LLM gibi yüksek verimli motorlar, standart PyTorch inference’ına kıyasla %30-80 arası hız artışı sağlayabilir.

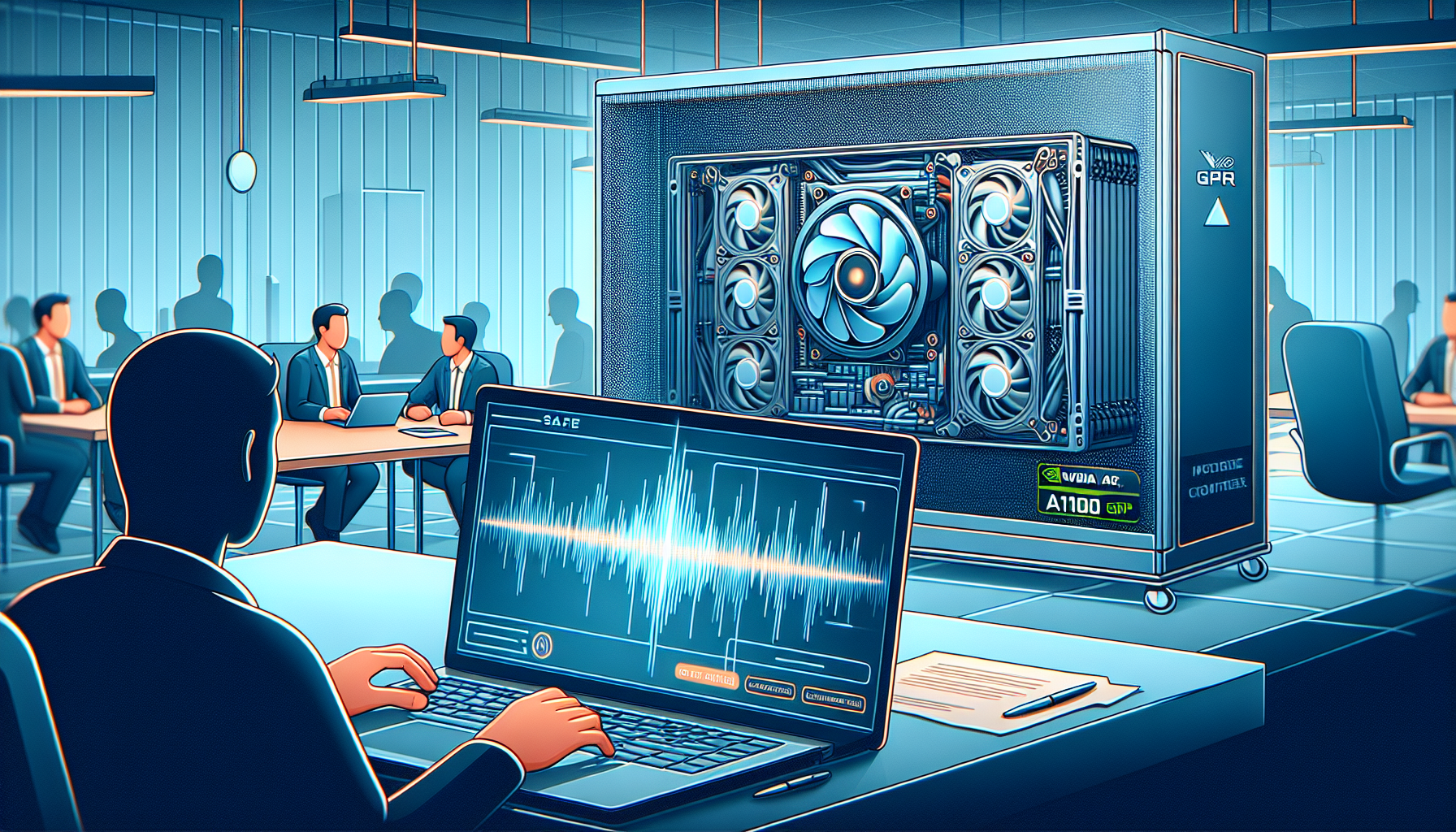

3. Stratejik Perspektif: TCO ve Performans Dengesi

Kendi GPU sunucunuzda hedeflenen token başına çıktı süresine ulaşmak, yalnızca teknik optimizasyon değil, aynı zamanda Toplam Sahip Olma Maliyeti (TCO) yönetimi ile ilgilidir.

– Bulut Modeli: Dakika başına GPU ücreti + ağ gecikmesi + veri gizliliği riski

– Özel Altyapı Modeli: Yüksek başlangıç maliyeti + düşük uzun vadeli token başına maliyet + tam veri kontrolü

Örneğin, 70B parametreli bir LLM’i günde 1 milyon token üretimi ile çalıştırmak, bulutta aylık 4.000 – 6.000 USD arası maliyet çıkarırken, HatipTek’in sağladığı özel GPU altyapısında bu maliyet donanım amortismanı dahil aylık 1.000 – 1.500 USD seviyesine inebilir.

4. Sonuç ve Öneri

LLM performansını optimize etmek, yalnızca model mimarisi veya GPU gücünü artırmakla sınırlı değildir. İlk token gecikmesi ile token başına çıktı süresini hedeflenen seviyeye çekmek, tam kontrol sahibi olduğunuz özel bir altyapı üzerinde mümkün hale gelir. Bu yaklaşım, hem kullanıcı deneyimini hem de operasyonel maliyetleri uzun vadede lehimize çevirir.

Eğer projenizde LLM çıkarım performansını milisaniyeler seviyesinde optimize etmek ve veri gizliliğini tamamen kontrol altına almak istiyorsanız, HatipTek ile iletişime geçin.

Bir yanıt yazın