-

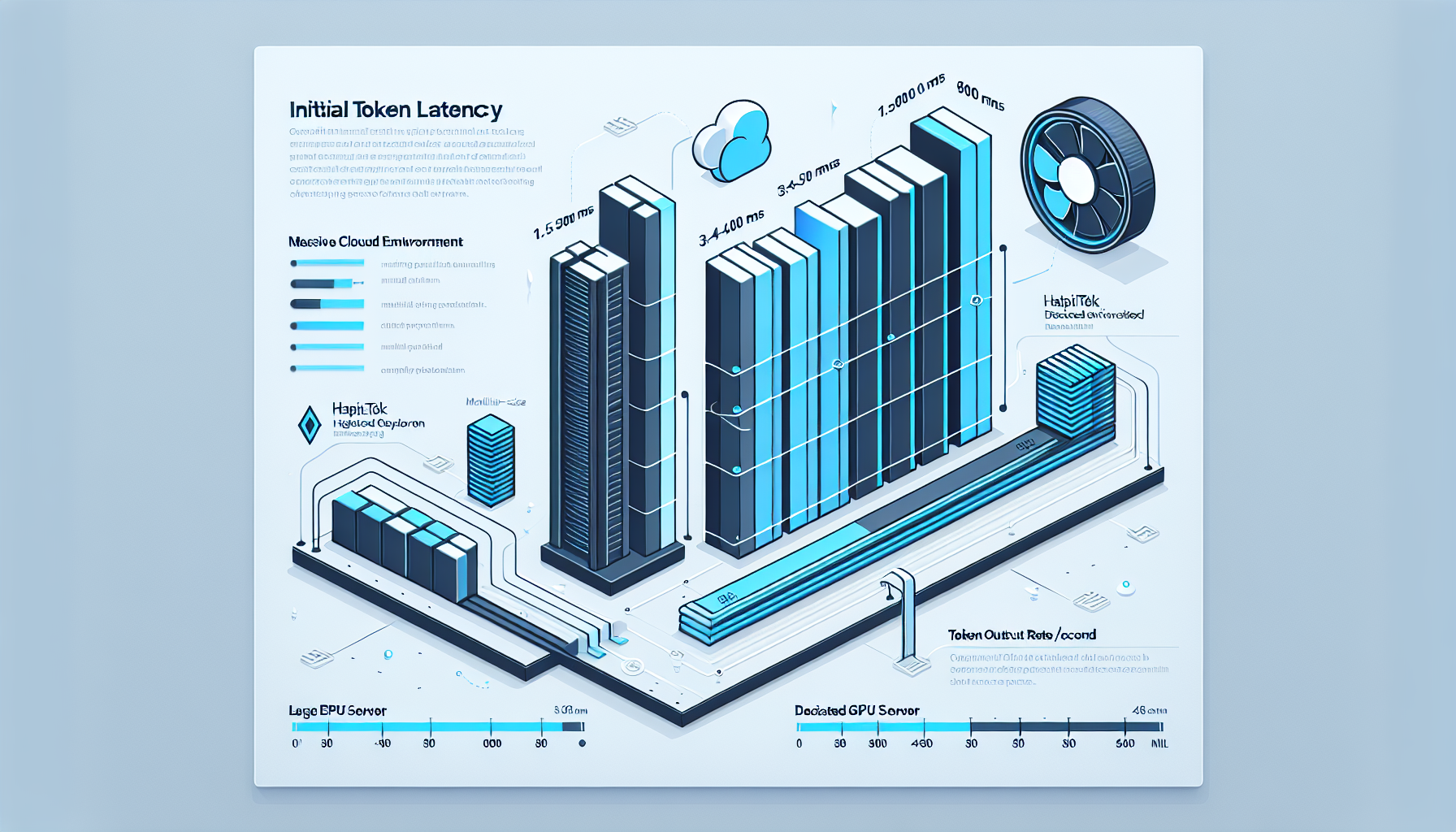

LLM’ler için ilk tokendan sonra hedeflenen token başına çıktı süresi (veya saniye başına token) nedir?

LLM Performansında Kritik Metrik: İlk Token Gecikmesi ve Token Başına Çıktı Süresi Büyük dil modelleri (LLM) ile çalışan her özel…

-

Tüm bileşenlerimin (GPU, CPU, RAM, vb.) toplam güç çekişi (Watt cinsinden) nedir?

GPU Odaklı Sunucularda Toplam Güç Tüketimini Hesaplamak: Kontrol Sizde Olsun Yapay zeka çıkarım (inference) ve özel altyapı gereksinimleri için tasarlanan…

-

Kendi verimle bir GPT modelini nasıl fine-tune edebilirim?

Kendi Verinizle GPT Modelini Fine-Tune Etmek: Özel GPU Sunucu Altyapısında Tam Kontrol Yapay zeka projelerinde, hazır GPT modelleri genellikle genel…

-

Nakliye, kurulum ve ilk kurulum maliyetleri nelerdir?

GPU Destekli Özel AI Sunucularında Nakliye, Kurulum ve İlk Kurulum Maliyetlerinin Stratejik Analizi Dijital egemenlik hedefleyen işletmeler için GPU destekli…

-

Sunucunun form faktörü nedir (örneğin, 1U, 2U, 4U rafa monte, kule)?

GPU Sunucularda Form Faktörü Seçimi: Performans, Yoğunluk ve Kontrol Dengesi Yapay zeka çıkarım (inference) ve özel altyapı uygulamalarında kullanılan GPU…

-

OpenAI’nin gelecekte halka arz olma ihtimali var mı?

OpenAI’nin Olası Halka Arzı: Yapay Zeka Altyapısında Kontrolü Kaybetmemek Yapay zeka ekosisteminin en kritik oyuncularından biri olan OpenAI, bugün küresel…

-

Beklenen kullanıcı trafiğime (S23-S25) dayanarak, hangi ağ bant genişliği gereklidir (örneğin, 1 GbE, 10 GbE, 25 GbE, 100 GbE)?

Yapay Zeka Sunucularında S23-S25 Trafik Tahminlerine Göre Ağ Bant Genişliği Seçimi Dijital altyapınızın geleceğini planlarken, özellikle GPU tabanlı yapay zeka…

-

Bu sunucu daha büyük bir kümenin parçası olacak mı ve sunucular arasında yüksek hızlı doğu-batı trafiği gerektirecek mi?

GPU Tabanlı Küme Mimarilerinde Doğu-Batı Trafiği: Stratejik Kontrolün Önemi Büyük ölçekli yapay zeka modelleri, HPC (High Performance Computing) uygulamaları veya…

-

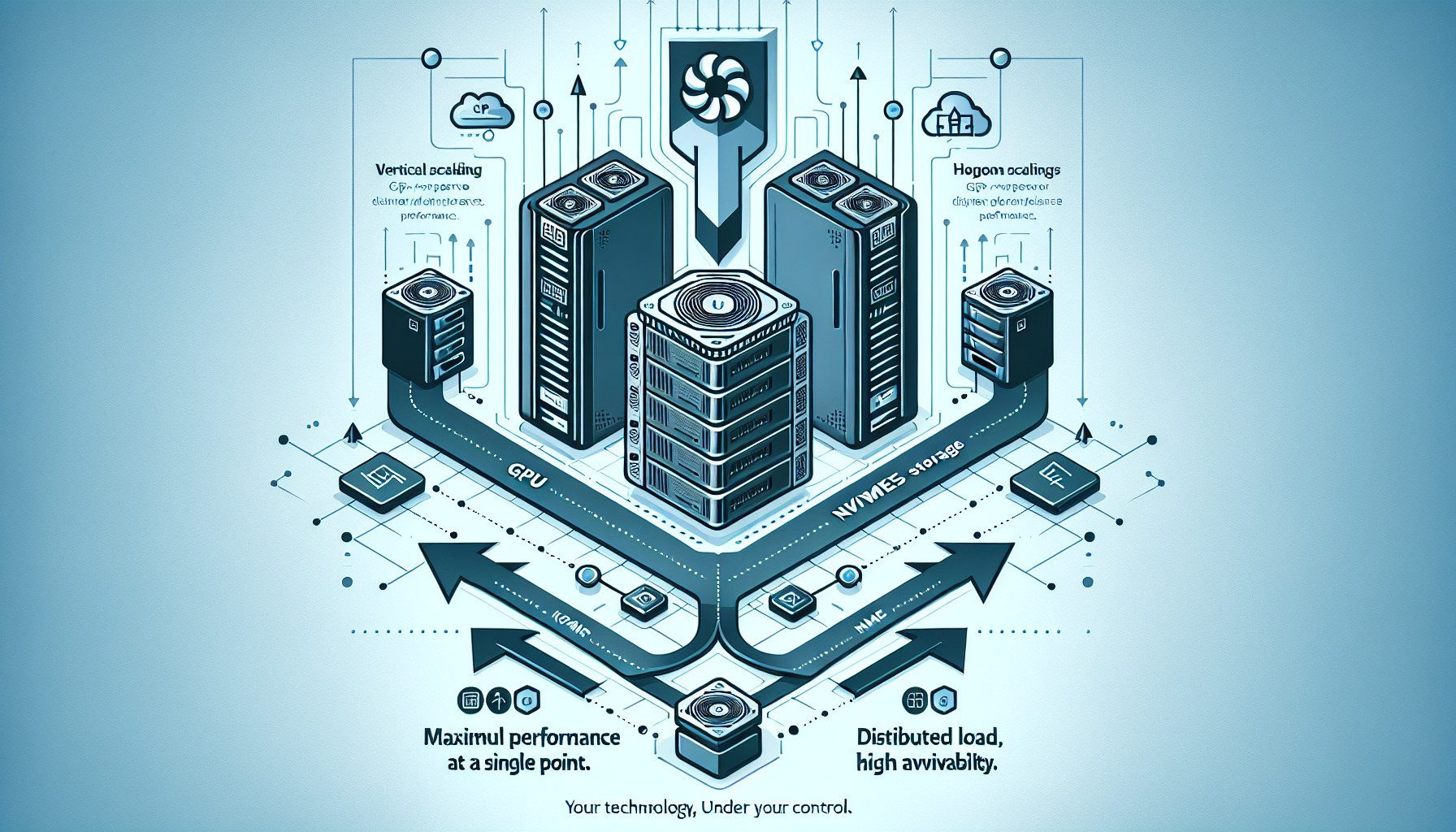

Ölçeklendirme stratejim nedir: dikey (bu sunucuya daha güçlü bileşenler eklemek) mi yoksa yatay (daha fazla sunucu eklemek) mi?

GPU Destekli AI Sunucularında Ölçeklendirme Stratejisi: Dikey mi, Yatay mı? Yapay zeka çıkarım (inference) ve özel altyapı gerektiren projeleriniz büyüdükçe,…

-

Model tek bir GPU’nun VRAM’ine sığıyor mu, yoksa çoklu GPU dağıtımı (tensör paralelliği) mı gerektirecek?

Yapay Zeka Modeliniz Tek GPU’da mı Çalışmalı, Yoksa Tensör Paralelliğine mi İhtiyacınız Var? Yapay zeka altyapısı kurarken kritik bir karar…